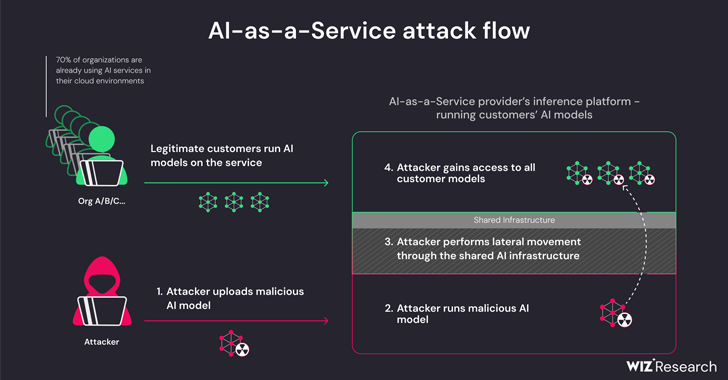

Новое исследование показало, что поставщики услуг с использованием искусственного интеллекта (ИИ), такие как Hugging Face, подвержены двум критическим рискам, которые могут позволить субъектам угрозы повышать привилегии, получать кросс-арендаторский доступ к моделям других клиентов и даже перехватывать конвейеры непрерывной интеграции и непрерывного развертывания (CI / CD).

"Вредоносные модели представляют серьезную опасность для систем искусственного интеллекта, особенно для поставщиков услуг искусственного интеллекта, поскольку потенциальные злоумышленники могут использовать эти модели для проведения атак между арендаторами", - сказали исследователи Wiz Шир Тамари и Саги Цадик.

"Потенциальное воздействие является разрушительным, поскольку злоумышленники могут получить доступ к миллионам частных моделей искусственного интеллекта и приложений, хранящихся у поставщиков услуг искусственного интеллекта".

Разработка происходит по мере того, как конвейеры машинного обучения превратились в совершенно новый вектор атаки на цепочку поставок, а репозитории, такие как Hugging Face, становятся привлекательной целью для проведения состязательных атак, направленных на сбор конфиденциальной информации и доступ к целевым средам.

Угрозы носят двусторонний характер и возникают в результате захвата инфраструктуры совместного вывода и захвата общего CI / CD. Они позволяют запускать ненадежные модели, загруженные в сервис в формате pickle, и перехватывать конвейер CI / CD для выполнения атаки на цепочку поставок.

Выводы фирмы, занимающейся облачной безопасностью, показывают, что можно взломать службу, использующую пользовательские модели, загрузив вредоносную модель и используя методы выхода из контейнера, чтобы вырваться из своего собственного клиента и скомпрометировать весь сервис, эффективно позволяя субъектам угрозы получать кросс-арендаторский доступ к моделям других клиентов, хранящимся и запускаемым в Hugging Face.

"Hugging Face по-прежнему позволяет пользователю определять загруженную модель на основе Pickle в инфраструктуре платформы, даже если это считается опасным", - уточнили исследователи.

По сути, это позволяет злоумышленнику создать модель PyTorch (Pickle) с возможностями выполнения произвольного кода при загрузке и связать ее с неправильными настройками в сервисе Amazon Elastic Kubernetes (EKS) для получения повышенных привилегий и горизонтального перемещения внутри кластера.

"Полученные нами секреты могли оказать значительное влияние на платформу, если бы они оказались в руках злоумышленника", - заявили исследователи. "Секреты в общих средах часто могут приводить к перекрестному доступу между арендаторами и утечке конфиденциальных данных.

Для устранения проблемы рекомендуется включить IMDSv2 с ограничением перехода, чтобы предотвратить доступ модулей к Службе метаданных экземпляра (IMDS) и получение роли узла в кластере.

Исследование также показало, что при запуске приложения в сервисе Hugging Face Spaces можно добиться удаленного выполнения кода через специально созданный Dockerfile и использовать его для извлечения и выталкивания (т. е. перезаписи) всех изображений, доступных во внутреннем реестре контейнеров.

Компания Hugging Face в скоординированном раскрытии информации заявила, что решила все выявленные проблемы. Также настоятельно рекомендуется пользователям использовать модели только из надежных источников, включать многофакторную аутентификацию (MFA) и воздерживаться от использования файлов pickle в производственных средах.

"Это исследование демонстрирует, что использование ненадежных моделей ИИ (особенно основанных на Pickle) может привести к серьезным последствиям для безопасности", - заявили исследователи. "Более того, если вы намерены разрешить пользователям использовать ненадежные модели искусственного интеллекта в вашей среде, чрезвычайно важно убедиться, что они работают в изолированной среде".

Раскрытие информации следует из другого исследования компании Lasso Security, согласно которому генеративные модели ИИ, такие как OpenAI ChatGPT и Google Gemini, могут распространять вредоносные (и несуществующие) пакеты кода ничего не подозревающим разработчикам программного обеспечения.

Другими словами, идея состоит в том, чтобы найти рекомендацию для неопубликованного пакета и опубликовать вместо него троянский пакет, чтобы распространять вредоносное ПО. Феномен галлюцинаций с пакетами ИИ подчеркивает необходимость проявлять осторожность при использовании больших языковых моделей (LLM) для кодирования решений.

Компания Anthropic, занимающаяся искусственным интеллектом, со своей стороны, также подробно описала новый метод, называемый "многоцелевым джейлбрейком", который может использоваться для обхода средств защиты, встроенных в LLM, для получения ответов на потенциально опасные запросы, используя контекстное окно моделей.

"Возможность ввода все более больших объемов информации имеет очевидные преимущества для пользователей LLM, но она также сопряжена с рисками: уязвимостями для джейлбрейков, которые используют более длительное контекстное окно", - заявила компания ранее на этой неделе.

В двух словах, этот метод включает в себя введение большого количества искусственных диалогов между человеком и помощником ИИ в рамках одного запроса для LLM в попытке "управлять поведением модели" и отвечать на запросы, которые в противном случае были бы невозможны (например, "Как мне создать бомбу?").