Teacher

Professional

- Messages

- 2,669

- Reaction score

- 819

- Points

- 113

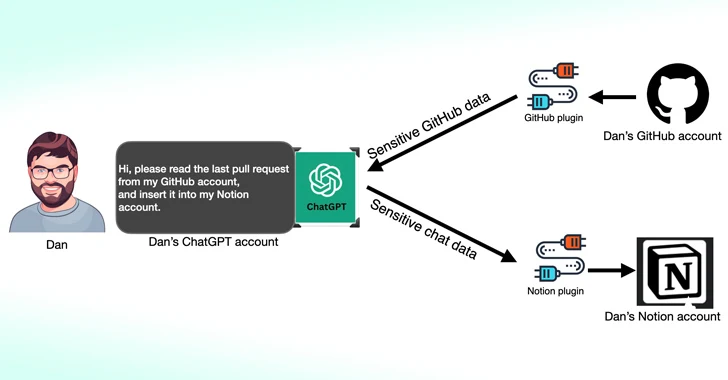

Исследователи кибербезопасности обнаружили, что сторонние плагины, доступные для OpenAI ChatGPT, могут служить новым средством атаки для злоумышленников, желающих получить несанкционированный доступ к конфиденциальным данным.

Согласно новому исследованию, опубликованному Salt Labs, недостатки безопасности, обнаруженные непосредственно в ChatGPT и внутри экосистемы, могут позволить злоумышленникам устанавливать вредоносные плагины без согласия пользователей и захватывать учетные записи на сторонних веб-сайтах, таких как GitHub.

Плагины ChatGPT, как следует из названия, представляют собой инструменты, предназначенные для работы поверх большой языковой модели (LLM) с целью доступа к актуальной информации, выполнения вычислений или доступа к сервисам сторонних производителей.

С тех пор OpenAI также представила GPTs, которые представляют собой индивидуальные версии ChatGPT, адаптированные для конкретных случаев использования, при этом уменьшая зависимость от сторонних сервисов. С 19 марта 2024 года пользователи ChatGPT больше не смогут устанавливать новые плагины или создавать новые диалоги с помощью существующих плагинов.

Один из недостатков, обнаруженных Salt Labs, связан с использованием рабочего процесса OAuth, чтобы обманом заставить пользователя установить произвольный плагин, воспользовавшись тем фактом, что ChatGPT не подтверждает, что пользователь действительно начал установку плагина.

Это фактически может позволить субъектам угрозы перехватывать и эксфильтрировать все данные, которыми делится жертва, которые могут содержать конфиденциальную информацию.

Компания по кибербезопасности также обнаружила проблемы с PluginLab, которые могут быть использованы злоумышленниками для проведения атак по захвату учетных записей без щелчка мыши, что позволяет им получить контроль над учетной записью организации на сторонних веб-сайтах, таких как GitHub, и получить доступ к их репозиториям исходного кода.

"'auth.pluginlab [.]ai / oauth / authorized ' не аутентифицирует запрос, что означает, что злоумышленник может вставить другой MemberID (он же жертва) и получить код, представляющий жертву ", - объяснил исследователь безопасности Авиад Кармель. "С помощью этого кода он может использовать ChatGPT и получать доступ к GitHub жертвы".

Идентификатор участника жертвы можно получить, запросив конечную точку "auth.pluginlab[.]ai/members/requestMagicEmailCode". Нет никаких доказательств того, что какие-либо пользовательские данные были скомпрометированы с помощью уязвимости.

Также в нескольких плагинах, включая Kesem AI, обнаружена ошибка управления перенаправлением OAuth, которая может позволить злоумышленнику украсть учетные данные учетной записи, связанные с самим плагином, отправив жертве специально созданную ссылку.

Разработка началась через несколько недель после того, как Imperva подробно описала две уязвимости межсайтового скриптинга (XSS) в ChatGPT, которые могут быть подключены для захвата контроля над любой учетной записью.

В декабре 2023 года исследователь в области безопасности Йоханн Ребергер продемонстрировал, как злоумышленники могут создавать пользовательские GPT, которые могут запрашивать учетные данные пользователя и передавать украденные данные на внешний сервер.

Новая атака удаленного кейлоггинга на помощников по искусственному интеллекту

Результаты также следуют из нового исследования, опубликованного на этой неделе, об атаке по побочному каналу LLM, в которой длина токена используется в качестве скрытого средства для извлечения зашифрованных ответов от помощников искусственного интеллекта через Интернет."LLM генерируют и отправляют ответы в виде серии токенов (похожих на слова), при этом каждый токен передается с сервера пользователю по мере его генерации", - заявила группа ученых из Университета Бен-Гуриона и Исследовательской лаборатории искусственного интеллекта Offensive.

"Хотя этот процесс зашифрован, последовательная передача токена открывает новый побочный канал: побочный канал длиной в токен. Несмотря на шифрование, размер пакетов может указывать на длину токенов, потенциально позволяя злоумышленникам в сети получать конфиденциальную информацию, которой делятся в частных беседах помощники ИИ."

Это достигается с помощью атаки с использованием токенов, которая предназначена для расшифровки ответов в зашифрованном трафике путем обучения модели LLM, способной переводить последовательности длиной в токены в их аналоги на естественном языке (т. е. Открытый текст).

Другими словами, основная идея состоит в том, чтобы перехватывать ответы в чате в реальном времени с провайдером LLM, использовать заголовки сетевых пакетов для определения длины каждого токена, извлекать и анализировать текстовые сегменты и использовать пользовательский LLM для вывода ответа.

Двумя ключевыми предпосылками для проведения атаки являются клиент чата с искусственным интеллектом, работающий в потоковом режиме, и злоумышленник, способный перехватывать сетевой трафик между клиентом и чат-ботом с искусственным интеллектом.

Чтобы снизить эффективность атаки по побочному каналу, компаниям, разрабатывающим помощников по искусственному интеллекту, рекомендуется применять случайное заполнение, чтобы скрыть фактическую длину токенов, передавать токены большими группами, а не по отдельности, и отправлять полные ответы сразу, а не по отдельности.

"Баланс безопасности с удобством использования и производительностью представляет собой сложную задачу, требующую тщательного рассмотрения", - заключили исследователи.