Father

Professional

- Messages

- 2,602

- Reaction score

- 837

- Points

- 113

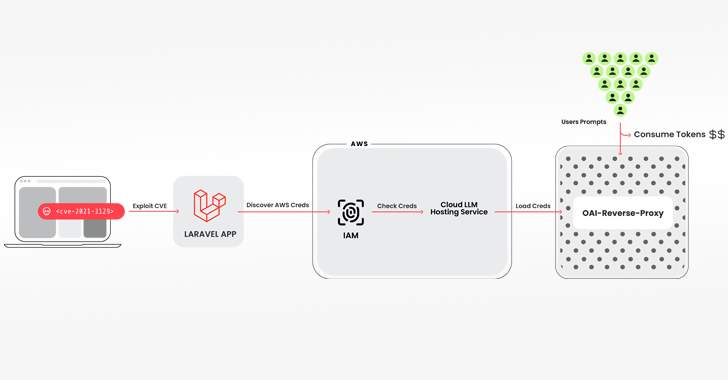

Исследователи кибербезопасности обнаружили новую атаку, в которой используются украденные облачные учетные данные для атаки на облачные сервисы большой языковой модели (LLM) с целью продажи доступа другим субъектам угрозы.

Метод атаки получил кодовое название LLMjacking от исследовательской группы Sysdig Threat Research Team.

"Как только был получен первоначальный доступ, они отфильтровали учетные данные из облака и получили доступ к облачной среде, где попытались получить доступ к локальным моделям LLM, размещенным у облачных провайдеров", - сказал исследователь безопасности Алессандро Брукато. "В данном случае целью была локальная модель LLM Claude (v2 / v3) от Anthropic".

Путь вторжения, используемый для реализации схемы, влечет за собой взлом системы, в которой запущена уязвимая версия платформы Laravel Framework (например, CVE-2021-3129), с последующим получением учетных данных Amazon Web Services (AWS) для доступа к службам LLM.

Среди используемых инструментов - скрипт Python с открытым исходным кодом, который проверяет и валидирует ключи для различных предложений от Anthropic, AWS Bedrock, Google Cloud Vertex AI, Mistral и OpenAI, среди прочих.

"На самом деле на этапе проверки не выполнялось никаких законных запросов LLM", - объяснил Брукато. "Вместо этого было сделано ровно столько, чтобы выяснить, на что способны учетные данные и какие квоты".

Программа проверки ключей также интегрирована с другим инструментом с открытым исходным кодом под названием oai-reverse-proxy, который функционирует как обратный прокси-сервер для LLM API, что указывает на то, что субъекты угрозы, вероятно, предоставляют доступ к скомпрометированным учетным записям, фактически не раскрывая базовые учетные данные.

"Если злоумышленники собирали список полезных учетных данных и хотели продать доступ к доступным моделям LLM, подобный обратный прокси-сервер мог бы позволить им монетизировать свои усилия", - сказал Брукато.

Кроме того, было замечено, что злоумышленники запрашивают настройки ведения журнала в вероятной попытке обойти обнаружение при использовании скомпрометированных учетных данных для запуска своих запросов.

Разработка представляет собой отход от атак, которые сосредоточены на быстрых инъекциях и отравлении моделей, вместо этого позволяя злоумышленникам монетизировать свой доступ к LLM, в то время как владелец облачной учетной записи оплачивает счета без их ведома или согласия.

Sysdig сказал, что атака такого рода может привести к увеличению затрат жертвы на потребление LLM более чем на 46 000 долларов в день.

"Использование услуг LLM может быть дорогостоящим, в зависимости от модели и количества вводимых в нее токенов", - сказал Брукато. "Максимизируя лимиты квот, злоумышленники также могут блокировать законное использование скомпрометированной организацией моделей, нарушая бизнес-операции".

Организациям рекомендуется включить подробное ведение журнала и отслеживать облачные журналы на предмет подозрительной или несанкционированной активности, а также обеспечить наличие эффективных процессов управления уязвимостями для предотвращения первоначального доступа.