Tomcat

Professional

- Messages

- 2,687

- Reaction score

- 1,036

- Points

- 113

Исследователи кибербезопасности обнаружили критический недостаток в системе безопасности Replicate поставщика искусственного интеллекта (ИИ) как услуги, который мог позволить субъектам угрозы получить доступ к проприетарным моделям ИИ и конфиденциальной информации.

"Использование этой уязвимости позволило бы получить несанкционированный доступ к подсказкам и результатам искусственного интеллекта всех клиентов платформы Replicate", - говорится в отчете компании Wiz, занимающейся облачной безопасностью, опубликованном на этой неделе.

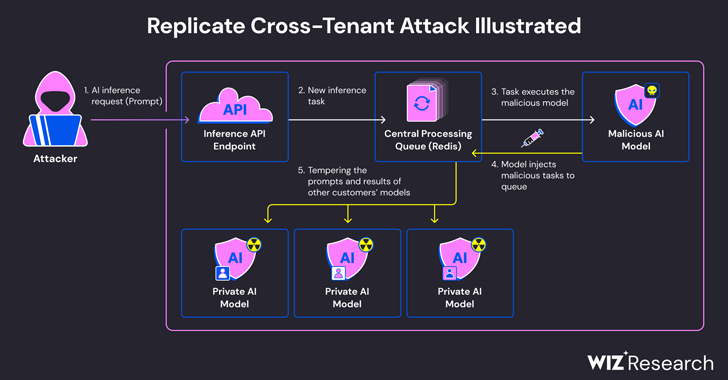

Проблема связана с тем фактом, что модели AI обычно упаковываются в форматы, допускающие выполнение произвольного кода, который злоумышленник может использовать для проведения кросс-клиентских атак с помощью вредоносной модели.

Replicate использует инструмент с открытым исходным кодом под названием Cog для контейнеризации и упаковки моделей машинного обучения, которые затем могут быть развернуты либо в автономной среде, либо для репликации.

Wiz заявила, что создала мошеннический контейнер Cog и загрузила его в Replicate, в конечном итоге используя его для удаленного выполнения кода в инфраструктуре сервиса с повышенными привилегиями.

"Мы подозреваем, что этот метод выполнения кода является шаблоном, при котором компании и организации запускают модели AI из ненадежных источников, даже если эти модели представляют собой код, который потенциально может быть вредоносным", - сказали исследователи безопасности Шир Тамари и Саги Цадик.

Затем разработанная компанией техника атаки использовала уже установленное TCP-соединение, связанное с экземпляром сервера Redis в кластере Kubernetes, размещенном на облачной платформе Google, для внедрения произвольных команд.

Более того, поскольку централизованный сервер Redis используется в качестве очереди для управления многочисленными запросами клиентов и их ответами, им можно злоупотреблять для облегчения кросс-клиентских атак путем вмешательства в процесс с целью вставки нестандартных задач, которые могут повлиять на результаты моделей других клиентов.

Эти мошеннические манипуляции не только угрожают целостности моделей искусственного интеллекта, но и создают значительные риски для точности и надежности результатов, управляемых искусственным интеллектом.

"Злоумышленник мог запросить частные модели AI клиентов, потенциально раскрыв проприетарные знания или конфиденциальные данные, задействованные в процессе обучения модели", - сказали исследователи. "Кроме того, перехват запросов мог привести к раскрытию конфиденциальных данных, включая личную информацию (PII).

Недостаток, который был ответственно раскрыт в январе 2024 года, с тех пор был устранен Replicate. Нет никаких доказательств того, что уязвимость использовалась в естественных условиях для компрометации данных клиентов.

Раскрытие происходит чуть более чем через месяц после того, как Wiz подробно описала исправленные риски на таких платформах, как Hugging Face, которые могут позволить субъектам угрозы повышать привилегии, получать кросс-арендаторский доступ к моделям других клиентов и даже взять на себя управление конвейерами непрерывной интеграции и непрерывного развертывания (CI / CD).

"Вредоносные модели представляют серьезную опасность для систем искусственного интеллекта, особенно для поставщиков искусственного интеллекта как услуги, поскольку злоумышленники могут использовать эти модели для проведения кросс-клиентских атак", - заключили исследователи.

"Потенциальное воздействие является разрушительным, поскольку злоумышленники могут получить доступ к миллионам частных моделей ИИ и приложений, хранящихся у поставщиков AI-as-a-service".